10 月 2 日,国际事务处理性能委员会公布了数据库最新性能测试结果,在 TPC-C 基准测试中,由阿里巴巴集团蚂蚁金服自主研发的分布式关系数据库 OceanBase 打破了由 Oracle 保持了 9 年的 TPC-C 基准性能测试世界纪录,不仅成为首个登榜的中国数据库,更一举拿下世界第一,对此,中国工程院院士、计算机专家李国杰评价道:「这是中国基础软件取得的重大突破!」 本文作者 CSDN 博客专家马超对 OceanBase 的物理架构、数据及控制流程进行了分析,并解读开源部分的源码来剖析 OceanBase 是如何勇夺 TPC-C 冠军的。

作者 | 马超,CSDN 博客专家 责编 | 唐小引 出品 | CSDN 博客 封图 | CSDN 付费下载自东方 IC 我国高科技基础平台又有重大突破,继阿里和腾讯以及众多国内老牌嵌入式厂商相继宣传开源 IoT 操作系统之后,今天据权威机构国际事务处理性能委员会(Transaction Processing Performance Council)官网披露,由阿里巴巴集团蚂蚁金服自主研发的关系数据库 OceanBase,在 TPC-C 基准测试中,打破了由美国公司 Oracle(甲骨文)保持了 9 年之久的世界记录,成为首个登顶该榜单的中国数据库产品。

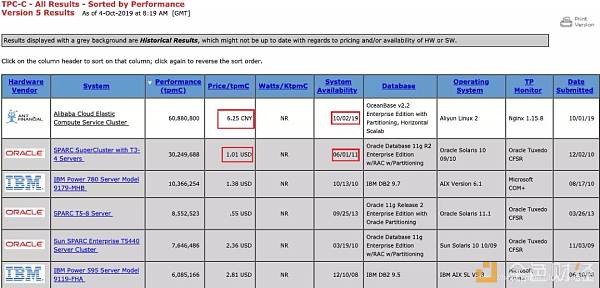

不过经笔者刚刚多次尝试,目前 TPC 的官网(www.tpc.org)并无法在国内访问,所以全部的信息只能出自这个截图,我们可以看到如下两个信息,一是这个排行榜是以 tpmC 为基准进行排名的,这里解释一下 tpmC 其实是 TPC-C 三标准的一种度量方式,tpmC 中的 tpm 是 transactions per minute 的简写,即每分钟的交易量,C 代表 C 基准程序。它的定义是每分钟内系统处理的新订单个数。在这方面阿里的 OceanBase 的确是遥遥领先。 TPC-C 还经常以系统性能价格比的方式体现,单位是$/tpmC,即以系统的总价格(单位是美元)/tpmC 数值得出。这个笔者也已经在上图中标红,可见这个参数按现行汇率来说阿里的优势不明显。而且考虑到甲骨文的测试提交时间是 2011 年,而阿里的测试时间则是今年的 10 月 2 日。因此由于笔者也没拿到测试报告的原文,所以甲骨文是否还是以 11 年的硬件价格来做为分母计算性价比指标也尚不得而知。 因而综上所述,阿里在性能指标上的确是做到了遥遥领先,但是可能在硬件价格以及测试时间的方面占了一些先机。 OceanBase 在哪些方面做对了? 根据 OceanBase 的官网[1]介绍,其总体物理架构如下:

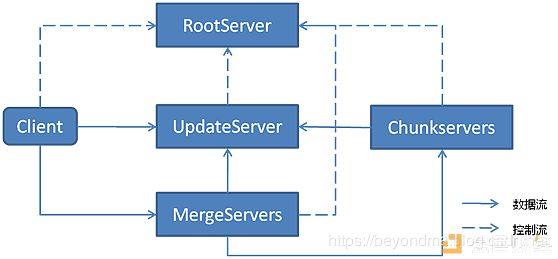

同时,从官网信息我们可以看到,OceanBase 在金融行业的应用案例为南京银行,因此笔者第一时间翻了一下南京银行朋友的票圈,了解了一下相关信息,目前南京分行在 OceanBase 上线的系统以互联网应用为主,而且根据其分享 OceanBase 在 Github 对自己的 0.4 版本进行了开源[2],目前虽然版本有更新,但是其基础设计没有根本改变,根据 GitHub 上的资源显示,其数据及控制流程总体如下:

OceanBase 将表的数据动态切分为 tablet,tablet 的数据分为动态和静态两部分。静态的数据存放在 chunkserver 上,所有对数据的修改都存储在 updateserver 中。updateserver 的修改定期同步到 chunkserver,chunkserver 将 updateserver 的更新和本地的静态数据合并,生成合并后的新数据。 tablet 的信息由 rootserver 维护,客户端在初始化时会请求 rootserver,获取 updateserver 的地址信息。客户端的更新请求(包括新增、修改和删除)都直接访问 updateserver。查询请求时客户端根据相应的 rowkey 向 rootserver 查询其对应的 tablet 信息,rootserver 返回相应的 mergeserver 地址,客户端根据返回的信息请求相应的 mergeserver 获取数据。 Mergeserver 收到请求时,根据 rowkey 从 rootserver 获取相应的 tablet 信息,该信息中包括负责该 tablet 的 chunkserver 列表,mergeserver 请求相应的 chunkserver,获取静态数据(如果有的话),然后根据返回的数据,请求 updateserver 获取相应的更新数据,将更新数据和静态的数据合并,将合并后的结果返回给客户端。 为了提高读取的性能,chunkserver 对部分数据结构进行了缓存。一个 SSTable 由多个 block 组成,为了加快定位需要请求的数据位于 SSTable 的哪个 block 中,chunkserver 包含一个 block index 的功能,block index 由该 block 负责的数据的最后一个 key 和该 block 在 SSTable 文件中的位置组成。为了提高 block 的读取性能,chunkserver 还将 block 缓存在内存中。Block index 和 block 的 cache 都采用 LRU 的策略淘汰。 笔者之前的博文中也介绍过,想提高效率必须做做减法,针对专门的场景做特定的优化。在笔者看到 OceanBase 的设计时,最令我印象深刻的是其 chunkserver 自带的缓存功能,而且根据之前的最佳实践分享,与甲骨文等传统数据库不同,OceanBase 与应用之间是不需要加 redius 缓存的,所以这点应该是阿里做的比传统数据库厂商厉害的地方。阿里的数据库之所以快基本上可以归功于这个 chunkserver 的功劳,下面我们就来进行一下代码解读。 速度秘诀:chunkserver 的设计与相关代码 其 chunkserver 的基础流程图如下:

可以看到负责数据查找和读取的部分是 SSTable 所以下面我们再对这部分做一下详细的代码解读,为便于查找,SSTable 会建立一些信息来索引数据,比如相关 key 在 SSTable 中的偏移,IndexBuilder 即用来建立这些信息。这部分的相关代码在: https://github.com/alibaba/oceanbase/tree/master/oceanbase_0.4/src/sstable/ob_sstable_block_index_builder.cpp 其中重点函数是这个生成入口的函数 add_entry,这些都写得比较清楚,大家可以看一下。 和这个函数生成 index 的函数: 并且,除了索引以外,OceanBase 还在读取之前添加了一个布隆过滤器,这个设计也比较有意思,Bloom Filter(布隆过滤器)用来判定某一个 key 是否属于某个集合,它有一定误判概率。如果判定在集合内,不一定在;但是如果判定不在集合内,那么一定不在,这样的操作可以优化很多 not in 的查询时间。这部分的代码在: https://github.com/alibaba/oceanbase/tree/master/oceanbase_0.4/src/common/bloom_filter.h https://github.com/alibaba/oceanbase/tree/master/oceanbase_0.4/src/common/bloom_filter.cpp 这里就不再贴代码了,大家有兴趣可以去上面的链接读一下相关代码。 后记 随着美国在高科技领域的不断施压,反而倒逼我国之前相对冷清的操作系统、数据库等基础平台领域重新热闹起来,笔者这个 C 语言的 IT 老兵感觉目前又焕发第二春,所以笔者还会继续关注相关领域的进展,后续继续带来代码级的解读,欢迎持续关注。 [1] https://oceanbase.alipay.com/product/oceanbase [2] https://github.com/alibaba/oceanbase —- 编译者/作者:CSDN 玩币族申明:玩币族作为开放的资讯翻译/分享平台,所提供的所有资讯仅代表作者个人观点,与玩币族平台立场无关,且不构成任何投资理财建议。文章版权归原作者所有。 |

200 行代码解读蚂蚁金服世界第一 数据库OceanBase

2019-10-06 CSDN 来源:区块链网络

LOADING...

相关阅读:

- 大数据时代数据泄露愈加频繁 IPFS/Filecoin掀起财富新机遇2020-08-04

- 快讯分析:数据显示比特币投资者没有被周日暴跌吓跑2020-08-03

- 从大数据分析,链游CZ官方打压平台币SOUL价格原因和成果2020-08-03

- 8/3.BTC凌晨空单建议250点已到位.反手多单建议再次完美获150个点.这波操2020-08-03

- 链博科技:生活在大数据时代的我们如何保护个人隐私?2020-08-03